mirror of

https://gitee.com/mymagicpower/AIAS.git

synced 2024-12-02 12:17:37 +08:00

| .. | ||

| app | ||

| gradle/wrapper | ||

| build.gradle | ||

| gradle.properties | ||

| gradlew | ||

| gradlew.bat | ||

| local.properties | ||

| README.md | ||

| settings.gradle | ||

官网:

2D虚拟人

最近元宇宙的概念越来越火。虚拟人技术是其中重要的组成部分。 其原理是通过视频来捕捉人脸,并且将人的面部动作同步到人物身上。人们只需要一个摄像头就可以制造出一个生动活泼的虚拟形象了。

虚拟数字人

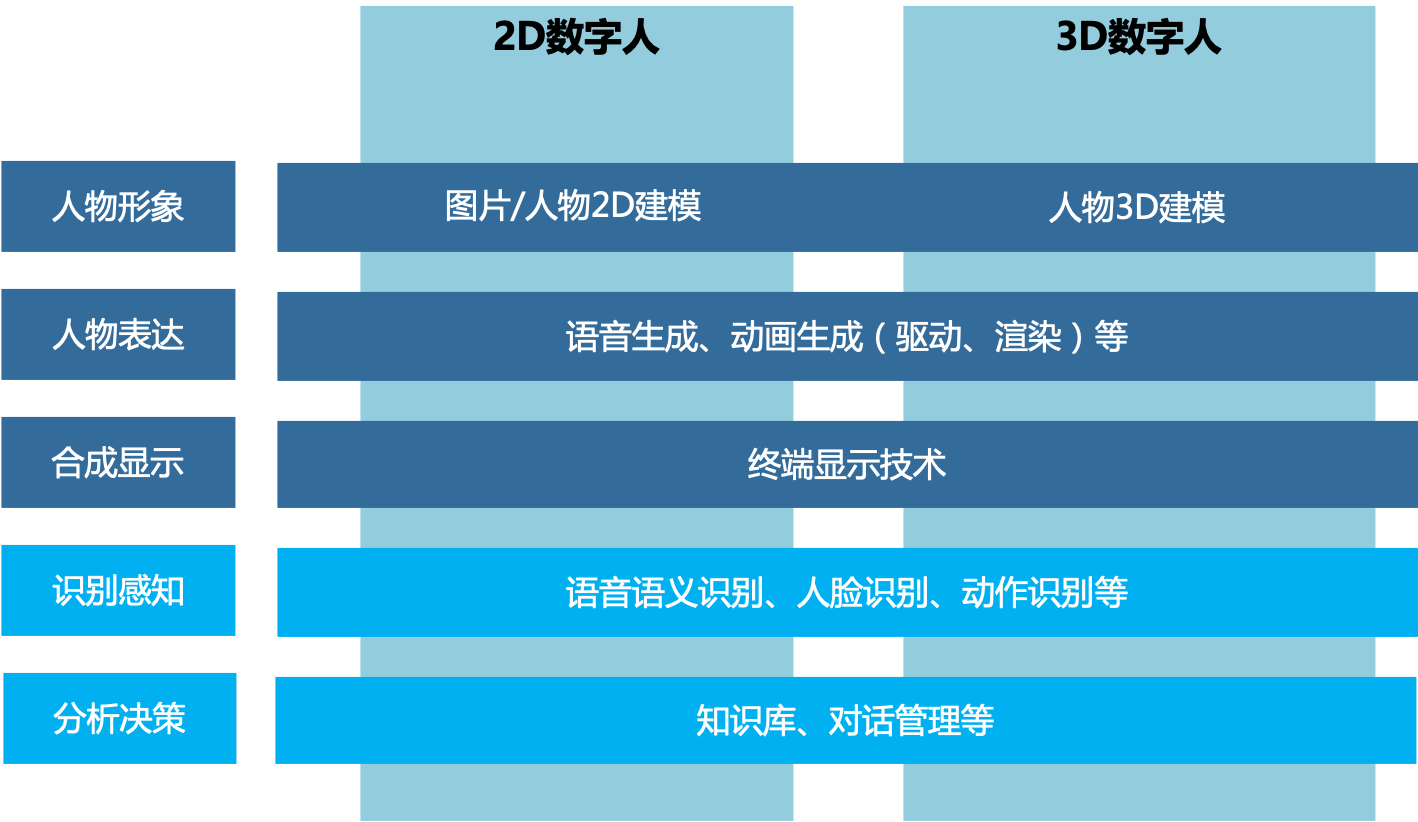

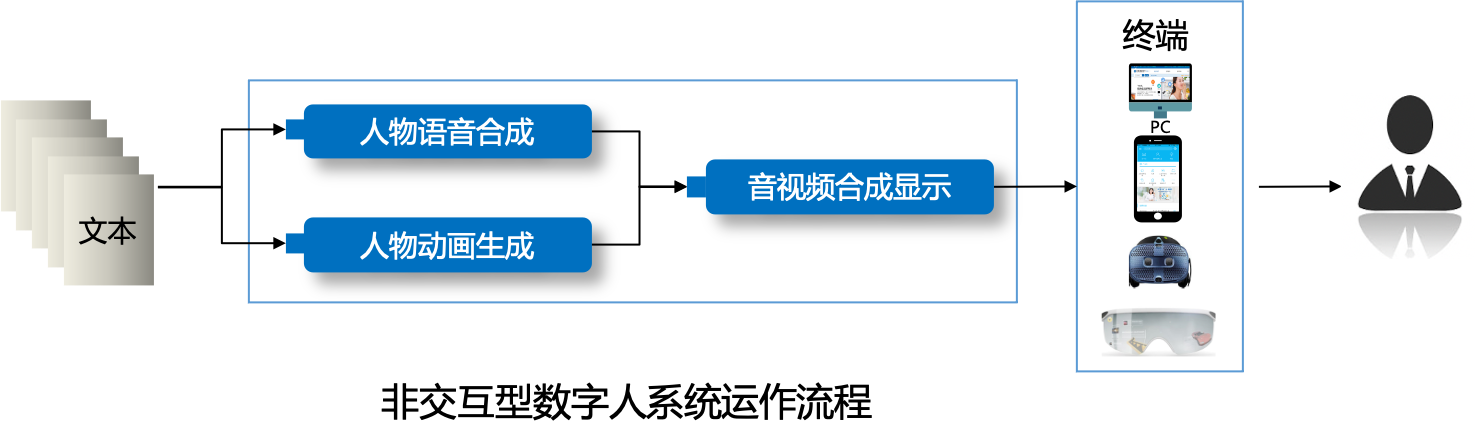

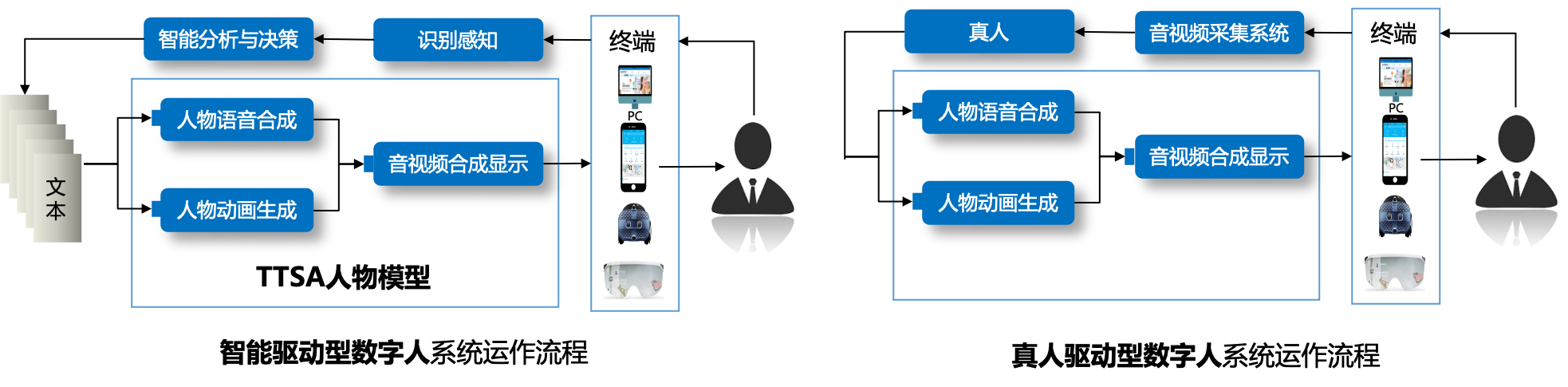

虚拟数字人系统一般情况下由人物形象、语音生成、动画生成、音视频合成显示、交互等5个模块构成:

- 人物形象根据人物图形资源的维度,可分为 2D 和 3D 两大类,从外形上又可分为卡通、 拟人、写实、超写实等风格;

- 语音生成模块和动画生成模块可分别基于文本生成对应的人物语音以及与之相匹配的人 物动画;

- 音视频合成显示模块将语音和动画合成视频,再显示给用户;

- 交互模块使数字人具备交互功能,即通过语音语义识别等智能技术识别用户的意图,并根据用户当前意图决定数字人后续的语音和动作,驱动人物开启下一轮交互。

交互模块

交互模块为扩展项,根据其有无,可将数字人分为交互型数字人和非交互型数字人。 交互型数字人根据驱动方式的不同可分为智能驱动型和真人驱动型。

目前app只能支持2D效果,也只能够支持面部表情的跟踪。要想拥有一个完整真实的虚拟形象,还需要3D技术的支持。 (这个demo使用的是live2d的旧版sdk,建议自行升级适配最新版sdk)

效果图:

官网:

2D虚拟偶像参考链接:

http://www.facerigcn.com/ https://www.live2dcn.com/